Hur definierar man ett heltäckande autonomt körsystem?

Den vanligaste definitionen är att ett "end-to-end"-system är ett system som matar in rå sensorinformation och direkt matar ut variabler av intresse för uppgiften. Till exempel, inom bildigenkänning kan CNN kallas "end-to-end" jämfört med den traditionella feature + classifier-metoden.

I autonoma köruppgifter matas data från olika sensorer (som kameror, LiDAR, Radar eller IMU...) in och fordonskontrollsignaler (som gaspådrag eller rattvinkel) matas ut direkt. För att överväga anpassningsproblemen för olika fordonsmodeller kan uteffekten också sänkas till fordonets körbana.

Baserat på denna grund har även modulära end-to-end-koncept vuxit fram, såsom UniAD, som förbättrar prestandan genom att införa övervakning av relevanta mellanliggande uppgifter, utöver de slutgiltiga styrsignalerna eller waypoints. Men utifrån en så snäv definition borde essensen av ände till ände vara förlustfri överföring av sensorisk information.

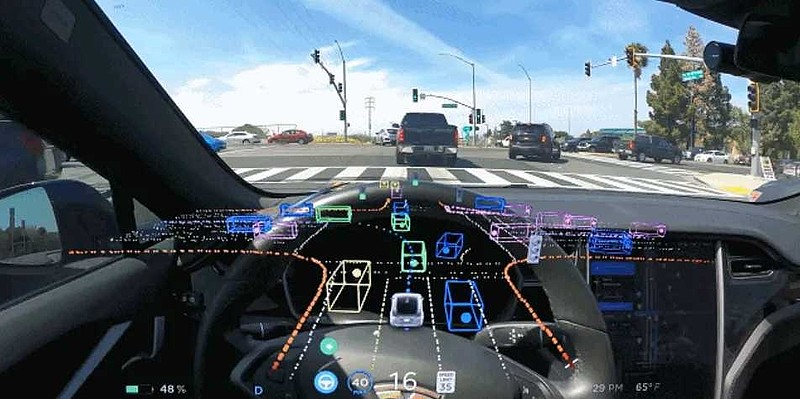

Låt oss först se över gränssnitten mellan avkännings- och PnC-moduler i icke-end-to-end-system. Vanligtvis upptäcker vi vitlistade objekt (som bilar, människor etc.) och analyserar och förutsäger deras egenskaper. Vi lär oss också om den statiska miljön (som vägstruktur, hastighetsbegränsningar, trafikljus etc.). Om vi var mer detaljerade skulle vi också upptäcka universella hinder. Kort sagt, informationen från dessa uppfattningar utgör en visningsmodell av komplexa körscener.

Men för vissa mycket uppenbara scener kan den nuvarande explicita abstraktionen inte helt beskriva de faktorer som påverkar körbeteendet i scenen, eller så är de uppgifter vi behöver definiera för triviala, och det är svårt att räkna upp alla nödvändiga uppgifter. Därför ger end-to-end-system en (kanske implicit) heltäckande representation med hopp om att automatiskt och förlustfritt agera på PnCs med denna information. Enligt min mening kan alla system som kan uppfylla detta krav kallas generaliserade ände-till-ände.

När det gäller andra frågor, såsom vissa optimeringar av dynamiska interaktionsscenarier, tror jag att åtminstone inte bara end-to-end kan lösa dessa problem, och end-to-end kanske inte är den bästa lösningen. Traditionella metoder kan lösa dessa problem, och naturligtvis, när mängden data är tillräckligt stor, kan end-to-end ge en bättre lösning.

Vissa missförstånd om end-to-end autonom körning

1. Styrsignaler och waypoints måste matas ut för att vara från ände till ände.

Om du håller med om det breda helhetskoncept som diskuterats ovan, är detta problem lätt att förstå. End-to-end bör betona förlustfri överföring av information snarare än att direkt mata ut uppgiftsvolymen. Ett smalt tillvägagångssätt kommer att orsaka många onödiga problem och kräva många hemliga lösningar för att garantera säkerheten.

2. End-to-end-systemet måste baseras på stora modeller eller ren vision.

Det finns inget nödvändigt samband mellan autonom körning från slut till ände, autonom körning av stora modeller och rent visuell autonom körning eftersom de är helt oberoende begrepp; ett end-to-end-system drivs inte nödvändigtvis av stora modeller, och det drivs inte nödvändigtvis av ren vision. av.

3. Är det på lång sikt möjligt för ovan nämnda end-to-end-system i snäv mening att uppnå autonom körning över L3-nivån?

Prestandan för det som för närvarande kallas ren end-to-end FSD är långt ifrån tillräcklig för att möta den tillförlitlighet och stabilitet som krävs på L3-nivå. För att uttrycka det mer rakt på sak, om det självkörande systemet vill accepteras av allmänheten, är nyckeln om allmänheten kan acceptera att i vissa fall kommer maskinen att göra misstag, och människor kan enkelt lösa dem. Detta är svårare för ett rent end-to-end-system.

Till exempel har både Waymo och Cruise i Nordamerika haft många olyckor. Men Cruises senaste olycka resulterade i två skador, även om sådana olyckor är ganska oundvikliga och acceptabla för mänskliga förare. Men efter denna olycka missbedömde systemet platsen för olyckan och platsen för de skadade och nedgraderades till pull-over-läge, vilket gjorde att de skadade drogs med länge. Detta beteende är oacceptabelt för alla normala mänskliga förare. Det kommer inte att göras, och resultaten kommer att bli mycket dåliga.

Dessutom är detta en väckarklocka att vi noga bör överväga hur vi ska undvika denna situation under utveckling och drift av autonoma körsystem.

4. Så för närvarande, vilka är de praktiska lösningarna för nästa generation av serietillverkade assisterade körsystem?

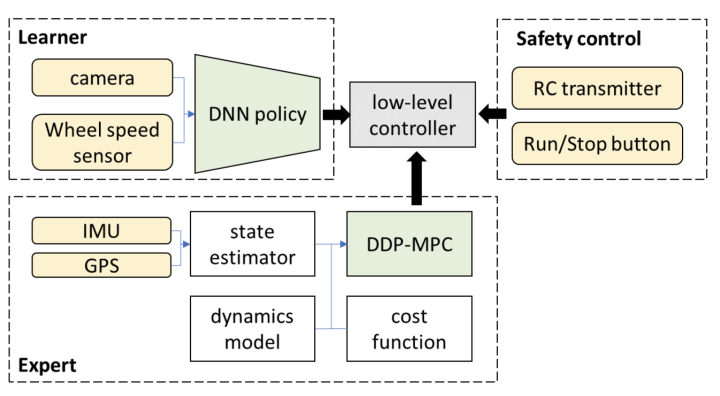

Enligt min nuvarande uppfattning, när man använder den så kallade end-to-end-modellen i körning, efter att ha matat ut banan, kommer den att returnera en lösning baserad på traditionella metoder. Alternativt matar inlärningsbaserade planerare och traditionella banplaneringsalgoritmer ut flera banor samtidigt och väljer sedan en bana genom en väljare.

Denna typ av hemlig lösning och val begränsar den övre gränsen för prestandan för detta kaskadsystem om denna systemarkitektur används. Om denna metod fortfarande bygger på ren återkopplingsinlärning kommer oförutsägbara misslyckanden att inträffa och målet att vara säker kommer inte att uppnås alls.

Om vi överväger att omoptimera eller välja med hjälp av traditionella planeringsmetoder på denna outputbana, är detta ekvivalent med den bana som produceras av den inlärningsdrivna metoden; därför, varför optimerar och söker vi inte direkt på den här banan?

Naturligtvis skulle vissa människor säga att ett sådant optimerings- eller sökproblem är icke-konvext, har ett stort tillståndsutrymme och är omöjligt att köra i realtid på ett system i fordon. Jag ber alla att noggrant överväga denna fråga: Under de senaste tio åren har perceptionssystemet fått minst hundra gånger så mycket beräkningskraftsutdelning, men hur är det med vår PnC-modul?

Om vi dessutom tillåter PnC-modulen att använda stor datorkraft, i kombination med vissa framsteg inom avancerade optimeringsalgoritmer under de senaste åren, är denna slutsats fortfarande korrekt? För denna typ av problem bör vi överväga vad som är korrekt från första principer.

5.Hur förenar man förhållandet mellan datadrivna och traditionella metoder?

Att spela schack är ett exempel som liknar autonom körning. I februari i år publicerade Deepmind en artikel som heter "Grandmaster-Level Chess Without Search", som diskuterade om det är möjligt att endast använda datadriven och överge MCTS-sökning i AlphaGo och AlphaZero. I likhet med autonom körning används endast ett nätverk för att direkt mata ut åtgärder, medan alla efterföljande steg ignoreras.

Artikeln drar slutsatsen att, trots stora mängder data och modellparametrar, kan ganska rimliga resultat erhållas utan att använda en sökning. Det finns dock betydande skillnader jämfört med metoder som använder sökning. Detta är särskilt användbart för att hantera vissa komplexa slutspel.

För komplexa scenarier eller hörnfall som kräver flerstegsspel gör denna analogi det fortfarande svårt att helt överge traditionella optimerings- eller sökalgoritmer. Att rimligen utnyttja fördelarna med olika tekniker som AlphaZero är det bästa sättet att förbättra prestandan.

6.Traditionell metod = regelbaserad om annat?

Jag har varit tvungen att korrigera detta koncept om och om igen medan jag pratat med många människor. Många tror att så länge det inte är rent datadrivet så är det inte regelbaserat. Inom schack är till exempel att memorera formler och schackrekord utantill regelbaserat, men liksom AlphaGo och AlphaZero ger det modellen möjligheten att vara rationell genom optimering och sökning. Jag tror inte att det kan kallas regelbaserat.

På grund av detta saknas just nu själva den stora modellen, och forskare försöker tillhandahålla en lärande-driven modell genom metoder som CoT. Men till skillnad från uppgifter som kräver ren datadriven bildigenkänning och oförklarliga skäl, har varje åtgärd av en person som kör en tydlig drivkraft.

Under lämplig algoritmarkitekturdesign bör beslutsbanan bli variabel och vara enhetligt optimerad under ledning av vetenskapliga mål, snarare än att tvångslappa och justera parametrar för att fixa olika fall. Ett sådant system har naturligtvis inte alla typer av hårdkodade konstiga regler.

Slutsats

Kort sagt, end-to-end kan vara en lovande teknisk väg, men hur konceptet tillämpas kräver mer forskning. Jag tror att ett gäng data och modellparametrar inte är den enda rätta lösningen, och om vi vill överträffa andra måste vi fortsätta jobba hårt.

Posttid: 2024-apr-24